Het Onthullen van de Hoge-Confidentie Valse Positieve Resultaten die Gezichtsherkenningssystemen Pesten: Hoe Overconfidente AI Fouten de Privacy, Justitie en Vertrouwen in Technologie Bedreigen

- Inleiding: Het Begrijpen van Hoge-Confidentie Valse Positieve Resultaten

- Hoe Gezichtsherkenningssystemen Vertrouwensscores Toekennen

- Reële Gevolgen: Valse Positieve Resultaten en Hun Impact

- Casestudies: Wanneer Overconfidente AI Fout Begaat

- Technische Oorzaken Achter Hoge-Confidentiefouten

- Bias, Gegevenskwaliteit en Systemische Kwetsbaarheden

- Juridische en Ethische Implicaties Voor Individuen en Samenleving

- Mitigatiestrategieën: Verminderen van Hoge-Confidentie Valse Positieve Resultaten

- Toekomstige Richtingen: Betrouwbare Gezichtsherkenning Opbouwen

- Conclusie: Het Herzien van AI-Confidence in Kritische Toepassingen

- Bronnen & Referenties

Inleiding: Het Begrijpen van Hoge-Confidentie Valse Positieve Resultaten

Gezichtsherkenningssystemen zijn steeds gebruikelijker geworden in beveiliging, wetshandhaving en consumentenapplicaties, belovend een snelle en nauwkeurige identificatie van individuen. Echter, een kritisch probleem blijft bestaan: het optreden van hoge-confidentie valse positieve resultaten. Dit zijn gevallen waarin het systeem per ongeluk het gezicht van een persoon koppelt aan een andere identiteit, maar dat doet met een hoge mate van algoritmische zekerheid. In tegenstelling tot lage-confidentiefouten, zijn hoge-confidentie valse positieven bijzonder zorgwekkend omdat ze eerder worden vertrouwd door menselijke operators en geautomatiseerde besluitvormingsprocessen, wat kan leiden tot ernstige gevolgen zoals onterechte arrestaties of het weigeren van diensten.

De onderliggende oorzaken van hoge-confidentie valse positieven zijn veelzijdig. Ze kunnen voortkomen uit bias in trainingsgegevens, algorithmische beperkingen of omgevingsfactoren zoals verlichting en camerahoeken. Opmerkelijk is dat onderzoek heeft aangetoond dat gezichtsherkenningssystemen vaak hogere foutpercentages vertonen voor bepaalde demografische groepen, wat het risico van hoge-confidentie verkeerde identificaties voor minderheden en vrouwen vergroot National Institute of Standards and Technology. Bovendien zijn de vertrouwensscores die door deze systemen worden gegenereerd niet altijd betrouwbare indicatoren van de werkelijke nauwkeurigheid, aangezien ze kunnen worden beïnvloed door de interne drempels en kalibratiemethoden van het systeem National Institute of Standards and Technology.

Het begrijpen en aanpakken van hoge-confidentie valse positieven is essentieel voor de verantwoordelijke inzet van gezichtsherkenningstechnologieën. Het vereist niet alleen technische verbeteringen in algoritmeontwerp en evaluatie, maar ook robuuste toezicht en transparantie om ervoor te zorgen dat de outputs van de systemen op de juiste manier worden geïnterpreteerd en waarop wordt gehandeld.

Hoe Gezichtsherkenningssystemen Vertrouwensscores Toekennen

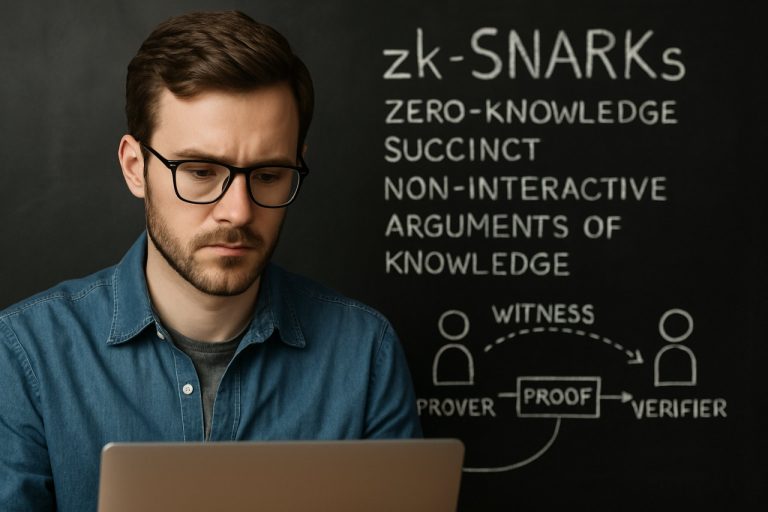

Gezichtsherkenningssystemen werken door unieke gezichtskenmerken uit een invoerafbeelding te extraheren en deze te vergelijken met een database van opgeslagen sjablonen. Het vergelijkingsproces levert een gelijkenisscore op, die kwantificeert hoe nauwkeurig de invoer overeenkomt met een kandidaat in de database. Deze gelijkenisscore wordt vervolgens omgezet in een vertrouwensscore – een probabilistische maat die de zekerheid van het systeem aangeeft dat de match correct is. Vertrouwensscores worden doorgaans genormaliseerd tussen 0 en 1, of uitgedrukt als een percentage, en worden gebruikt om te bepalen of een match moet worden geaccepteerd of afgewezen op basis van een vooraf bepaalde drempel.

De toekenning van vertrouwensscores omvat complexe algoritmen, vaak gebruik makend van diepe neurale netwerken die zijn getraind op grote datasets. Deze algoritmen analyseren gezichtskenmerken, textuur en ruimtelijke relaties, en produceren embedings die worden vergeleken met afstandsmetingen zoals cosinus-gelijkheid of Euclidische afstand. De resulterende score weerspiegelt de interne beoordeling van het systeem van matchkwaliteit, maar garandeert geen nauwkeurigheid. Factoren zoals beeldkwaliteit, posevariatie, verlichting en demografische bias kunnen de score beïnvloeden, wat soms leidt tot hoge-confidentie matches die in werkelijkheid onjuist zijn – de zogenaamde hoge-confidentie valse positieven.

Leveranciers en agentschappen kunnen verschillende drempels instellen voor acceptabele vertrouwen, waarbij de afweging tussen valse positieven en valse negatieven wordt gebalanceerd. Echter, zoals benadrukt door National Institute of Standards and Technology, kunnen zelfs bij hoge vertrouwensniveaus valse positieven optreden, vooral in grootschalige inzet of met niet-representatieve trainingsgegevens. Het begrijpen van hoe vertrouwensscores worden toegewezen is cruciaal voor het interpreteren van systeemoutputs en het mitigeren van de risico’s die samenhangen met hoge-confidentie valse positieven.

Reële Gevolgen: Valse Positieve Resultaten en Hun Impact

Hoge-confidentie valse positieven in gezichtsherkenningssystemen treden op wanneer het algoritme verkeerdelijk het gezicht van een individu koppelt aan een andere persoon in de database met een hoge mate van zekerheid. Deze fouten zijn bijzonder zorgwekkend omdat de vertrouwensscore van het systeem menselijke operators en geautomatiseerde processen kan doen vertrouwen op het resultaat zonder verdere verificatie. In reële scenario’s, zoals wetshandhaving, grenscontrole en publieke surveillance, kunnen deze fouten ernstige gevolgen hebben voor individuen en de samenleving.

Bijvoorbeeld, verschillende gedocumenteerde gevallen hebben aangetoond dat onschuldige mensen onterecht zijn gearresteerd of onderzocht vanwege hoge-confidentie valse overeenkomsten. In de Verenigde Staten zijn meerdere onterechte arrestaties in verband gebracht met fouten in gezichtsherkenning, wat onevenredig veel mensen van kleur treft vanwege algorithmische bias en lagere nauwkeurigheidspercentages voor niet-witte gezichten National Institute of Standards and Technology. Dergelijke incidenten kunnen leiden tot emotionele distress, reputatieschade en zelfs verlies van werk voor de betrokken individuen.

Naast persoonlijke gevolgen kunnen hoge-confidentie valse positieven het publieke vertrouwen in technologie en instituten ondermijnen. Wanneer het publiek zich bewust wordt van deze fouten, vooral in contexten met grote inzet, kan dit leiden tot weerstand tegen de inzet van gezichtsherkenningssystemen en oproepen tot strengere regelgeving of zelfs totale verboden Amnesty International. Bovendien kan overmatige afhankelijkheid van geautomatiseerde beslissingen de menselijke controle verminderen, waardoor het risico van ongecontroleerde fouten toeneemt. Het aanpakken van deze problemen vereist niet alleen technische verbeteringen, maar ook robuuste beleidskaders en transparantie bij de inzet van systemen.

Casestudies: Wanneer Overconfidente AI Fout Begaat

Hoge-confidentie valse positieven in gezichtsherkenningssystemen hebben geleid tot verschillende spraakmakende verkeerde identificaties, wat de risico’s van overmatige afhankelijkheid van AI-gedreven beslissingen onderstreept. Een opmerkelijk geval vond plaats in Detroit, waar gezichtsherkenningssoftware Robert Williams, een Afro-Amerikaanse man, verkeerd identificeerde als verdachte in een winkeldiefstalonderzoek. Ondanks het hoge vertrouwen van het systeem in de match, werd Williams ten onrechte gearresteerd en vastgehouden, wat de ernstige gevolgen van algorithmische overmoed en het gebrek aan menselijke controle in kritische besluitvormingsprocessen benadrukt (American Civil Liberties Union).

Een ander voorval betrof de Metropolitan Police in Londen, waarvan de live gezichtsherkenningstests resulteerden in een valse positieve score van 96%, waarbij het systeem vaak onschuldige individuen als verdachten met hoge vertrouwen aanmerkte. Deze fouten waren niet alleen frequent, maar troffen ook onevenredig veel mensen van kleur, wat vragen oproept over zowel technische nauwkeurigheid als systemische bias (London Assembly).

Dergelijke gevallen tonen aan dat hoge-confidentiescores geen garantie bieden voor correctheid; ze kunnen eerder onderliggende tekortkomingen in trainingsgegevens, algorithmisch ontwerp of operationele context maskeren. De aanhoudendheid van deze fouten, vooral wanneer vergezeld van ongegronde zekerheid, heeft geleid tot oproepen voor strengere regulering, transparantie en de integratie van menselijke beoordeling bij de inzet van gezichtsherkenningstechnologieën (National Institute of Standards and Technology).

Technische Oorzaken Achter Hoge-Confidentiefouten

Hoge-confidentie valse positieven in gezichtsherkenningssystemen treden op wanneer het algoritme een hoge waarschijnlijkheid toekent aan een onjuiste match, wat vaak leidt tot significante gevolgen in de echte wereld. Verschillende technische factoren dragen bij aan deze fouten. Een primaire oorzaak is het overfitten van diepe leermodellen aan bevoordeelde of niet-representatieve trainingsdatasets. Wanneer trainingsdata niet divers is in termen van leeftijd, etniciteit, verlichting of pose, kan het model onjuist correlaties leren, resulterend in hoge-confidentie matches voor individuen die oppervlakkige kenmerken delen maar niet dezelfde persoon zijn. Dit probleem is belicht in audits door het National Institute of Standards and Technology, dat aanzienlijke demografische verschillen in valse positieve percentages aantrof.

Een andere technische oorzaak is het gebruik van gelijkenisdrempels die niet dynamisch worden aangepast voor context of populatie. Veel systemen gebruiken een vaste gelijkenisscore-drempel om overeenkomsten te bepalen, maar dit houdt geen rekening met de natuurlijke variabiliteit in gezichtskenmerken tussen verschillende groepen. Als gevolg hiervan kan het systeem een hoge-confidentie match retourneren, zelfs wanneer de onderliggende featurevectors niet voldoende onderscheidend zijn, vooral in grootschalige identificatiescenario’s (NIST Face Recognition Vendor Test).

Bovendien kunnen vijandige aanvallen en beeldkwaliteitsproblemen—zoals lage resolutie, occlusies of compressie-artifacten—de feature-extractie verstoren, waardoor het model hoge vertrouwen toekent aan onjuiste matches. Deze technische kwetsbaarheden onderstrepen de noodzaak voor robuuste modelbeoordeling, diverse trainingsdata en adaptieve drempels om hoge-confidentie valse positieven in gezichtsherkenningssystemen te mitigeren.

Bias, Gegevenskwaliteit en Systemische Kwetsbaarheden

Hoge-confidentie valse positieven in gezichtsherkenningssystemen zijn vaak geworteld in kwesties van bias, gegevenskwaliteit en systemische kwetsbaarheden. Deze systemen, die zich baseren op grote datasets voor het trainen van hun algoritmen, kunnen bestaande biases in de gegevens overnemen en zelfs versterken. Als een trainingsdataset bijvoorbeeld bepaalde demografische groepen ondervertegenwoordigt, is het systeem mogelijk minder nauwkeurig voor die populaties, wat leidt tot een hoger percentage valse positieven—soms met onterecht hoge vertrouwensscores. Dit fenomeen is gedocumenteerd in studies door organisaties zoals het National Institute of Standards and Technology (NIST), die hebben aangetoond dat gezichtsherkenningsalgoritmen vaak ongelijk presteren tussen verschillende rassen, geslachten en leeftijdsgroepen.

Gegevenskwaliteit is een andere kritieke factor. Slecht gelabelde, lage-resolutie of niet-representatieve afbeeldingen kunnen de systeemprestaties verslechteren, wat de kans op onjuiste matches vergroten die het systeem desondanks als zeer betrouwbaar beoordeelt. Deze fouten zijn bijzonder zorgwekkend in toepassingen met hoge inzet zoals wetshandhaving of grenscontrole, waar een hoge-confidentie valse positief kan leiden tot onterechte detentie of het weigeren van diensten. Systemische kwetsbaarheden, zoals gebrek aan transparantie in algorithmische besluitvorming en onvoldoende toezicht, verergeren de risico’s verder. Zonder robuuste audit- en verantwoordingsmechanismen wordt het moeilijk om deze hoge-confidentie fouten te detecteren en te corrigeren, waardoor ze blijven bestaan en potentieel schade aanrichten.

Het aanpakken van deze uitdagingen vereist niet alleen technische verbeteringen—zoals meer diverse en representatieve trainingsdatasets—maar ook beleidsinterventies en onafhankelijke evaluaties om eerlijke en betrouwbare gezichtsherkenninginzet te waarborgen. Voortdurend onderzoek en regelgevende controle, zoals gepleit door entiteiten zoals het European Parliament Committee on Civil Liberties, Justice and Home Affairs, zijn essentieel om de impact van bias, slechte gegevenskwaliteit en systemische kwetsbaarheden in deze systemen te mitigeren.

Juridische en Ethische Implicaties Voor Individuen en Samenleving

Hoge-confidentie valse positieven in gezichtsherkenningssystemen—gevallen waarin de technologie een individu onterecht koppelt aan een database-entry met hoge zekerheid—vormen aanzienlijke juridische en ethische uitdagingen voor zowel individuen als de samenleving. Juridisch kunnen dergelijke fouten leiden tot onterechte detentie, arrestatie of het weigeren van diensten, wat vragen oproept over het rechtsproces en de onschuldpresumptie. Verschillende gedocumenteerde gevallen in de Verenigde Staten hebben aangetoond dat individuen ten onrechte als verdachten in strafrechtelijke onderzoeken werden geïdentificeerd, wat resulteerde in onrechtvaardige opsluiting en reputatieschade American Civil Liberties Union. Deze incidenten benadrukken het potentieel van gezichtsherkenning om fundamentele rechten die wettelijk zijn beschermd, zoals het recht op privacy en bescherming tegen onredelijke doorzoekingen, te ondermijnen.

Ethisch roept de inzet van systemen die gevoelig zijn voor hoge-confidentie valse positieven vragen op over rechtvaardigheid, verantwoordelijkheid en transparantie. Marginaliseerde groepen, met name mensen van kleur en vrouwen, worden onevenredig getroffen vanwege gedocumenteerde biases in gezichtsherkenningsalgoritmen National Institute of Standards and Technology. Dit verergert bestaande sociale ongelijkheden en kan het publieke vertrouwen in wetshandhaving en overheidssystemen ondermijnen. Bovendien betekent het gebrek aan duidelijke regelgevende kaders en toezichtmechanismen dat individuen vaak beperkte middelen hebben om onterechte identificaties aan te vechten of te corrigeren European Parliament.

Het aanpakken van deze juridische en ethische implicaties vereist robuuste waarborgen, waaronder transparante audits, duidelijke mogelijkheden voor herstel en strikte beperkingen op het gebruik van gezichtsherkenning in gevoelige contexten. Zonder dergelijke maatregelen dreigen de risico’s van hoge-confidentie valse positieven de potentiële voordelen van deze technologieën te overschaduwden.

Mitigatiestrategieën: Verminderen van Hoge-Confidentie Valse Positieve Resultaten

Het mitigeren van hoge-confidentie valse positieven in gezichtsherkenningssystemen vereist een veelzijdige aanpak die zowel technische als operationele factoren aanpakt. Een effectieve strategie is de implementatie van meer robuuste en diverse trainingsdatasets. Door ervoor te zorgen dat datasets een breed scala aan demografische variabelen bevatten—zoals leeftijd, geslacht en etniciteit—kunnen ontwikkelaars het risico van bias dat vaak leidt tot onjuiste hoge-confidentie matches verminderen National Institute of Standards and Technology. Bovendien kan het integreren van geavanceerde algoritmen die multimodale biometrie gebruiken (bijv. het combineren van gezichtsherkenning met stem- of loopanalyse) aanvullende verificatie bieden, waardoor de kans op valse positieven wordt verlaagd National Institute of Standards and Technology.

Een andere kritieke mitigatiestrategie betreft de kalibratie van vertrouwensdrempels. Door deze drempels dynamisch aan te passen op basis van context—zoals het beveiligingsniveau van de applicatie of de kwaliteit van de invoerafbeelding—kunnen systemen overmatige afhankelijkheid van hoge-confidentiescores vermijden die misleidend kunnen zijn Federal Bureau of Investigation. Bovendien zorgt het opnemen van menselijke beoordeling in hoge-inzet beslissingen ervoor dat geautomatiseerde matches onderhevig zijn aan deskundige controle voordat er enige ingrijpende actie wordt ondernomen.

Ten slotte is voortdurende monitoring en auditing van systeemprestaties essentieel. Regelmatig evalueren van valse positieve percentages en het uitvoeren van biasbeoordelingen kan organisaties helpen opkomende problemen te identificeren en hun mitigatiestrategieën dienovereenkomstig aan te passen National Institute of Standards and Technology. Deze gecombineerde inspanningen zijn cruciaal om het optreden en de impact van hoge-confidentie valse positieven in gezichtsherkenningssystemen te verminderen.

Toekomstige Richtingen: Betrouwbare Gezichtsherkenning Opbouwen

Naarmate gezichtsherkenningssystemen steeds meer geïntegreerd worden in beveiliging, wetshandhaving en commerciële toepassingen, is het aanpakken van de uitdaging van hoge-confidentie valse positieven cruciaal voor het opbouwen van betrouwbare technologie. Hoge-confidentie valse positieven treden op wanneer een systeem onterecht het gezicht van een individu koppelt aan dat van een ander met een hoge mate van zekerheid, wat vaak leidt tot ernstige gevolgen zoals onterechte arrestaties of het weigeren van diensten. Toekomstige richtingen in het mitigeren van deze fouten richten zich zowel op technische als beleidsgerichte oplossingen.

Op technisch gebied vordert het onderzoek naar robuustere algoritmen die beter rekening kunnen houden met demografische diversiteit, omgevingscondities en beeldkwaliteit. Het incorporeren van multimodale biometrie—zoals het combineren van gezichtsherkenning met stem- of loopanalyse—kan de afhankelijkheid van één modaliteit verminderen en het risico op valse positieven verlagen. Bovendien is de ontwikkeling van uitlegbare AI-modellen gericht op het bieden van transparantie in besluitvorming, waarmee gebruikers en auditeurs kunnen begrijpen waarom een bepaalde match is gemaakt en onjuiste resultaten kunnen aanvechten National Institute of Standards and Technology.

Vanuit een beleidspersectief is het essentieel om gestandaardiseerde benchmarks en onafhankelijke audits vast te stellen voor het evalueren van systeemprestaties in verschillende populaties en scenario’s. Regelgevende kaders die menselijke controle in hoge-inzet toepassingen verplicht stellen, kunnen verdere bescherming bieden tegen de gevolgen van hoge-confidentie fouten. Publieke betrokkenheid en duidelijke communicatie over de beperkingen van systemen zijn ook van vitaal belang voor het behouden van vertrouwen en ervoor te zorgen dat gezichtsherkenningstechnologieën verantwoord worden ingezet European Data Protection Board.

Uiteindelijk vereist het opbouwen van betrouwbare gezichtsherkenningssystemen een holistische aanpak die technische innovatie, rigoureuze evaluatie en transparant bestuur combineert om hoge-confidentie valse positieven en hun maatschappelijke impact te minimaliseren.

Conclusie: Het Herzien van AI-Confidence in Kritische Toepassingen

De prevalentie van hoge-confidentie valse positieven in gezichtsherkenningssystemen benadrukt de dringende noodzaak om te heroverwegen hoe AI vertrouwensscores worden geïnterpreteerd en gebruikt, vooral in kritische toepassingen zoals wetshandhaving, grenscontrole en beveiliging. Deze systemen wijzen vaak hoge vertrouwensniveaus toe aan onjuiste matches, wat kan leiden tot potentieel ernstige gevolgen voor individuen die door de technologie verkeerd zijn geïdentificeerd. Dergelijke fouten zijn niet louter technische tekortkomingen; ze kunnen resulteren in onterechte detenties, privacyschendingen en een erosie van het publieke vertrouwen in AI-gedreven processen. Recente evaluaties door organisaties zoals het National Institute of Standards and Technology hebben aangetoond dat zelfs de meest geavanceerde algoritmen hoge-confidentiefouten kunnen produceren, vooral wanneer ze worden getest op diverse demografische groepen.

Om deze uitdagingen aan te pakken, is het van essentieel belang om verder te kijken dan de afhankelijkheid van ruwe vertrouwensscores als indicatoren van nauwkeurigheid. In plaats daarvan is een meer genuanceerde aanpak vereist—een die rigoureuze nabewerking, menselijke controle en contextbewuste drempels voor besluitvorming omvat. Bovendien moet transparantie in hoe vertrouwensscores worden gegenereerd en geïnterpreteerd prioriteit krijgen, zodat belanghebbenden beter begrijpen wat de beperkingen en risico’s zijn die aan deze systemen kleven. Naarmate AI blijft doordringen in omgevingen met hoge inzet, is het essentieel om de rol van vertrouwen in geautomatiseerde besluitvorming te heroverwegen om schade te mitigeren en rechtvaardige uitkomsten te waarborgen. Uiteindelijk zal het bevorderen van een cultuur van kritische evaluatie en continue verbetering cruciaal zijn voor het verantwoord inzetten van gezichtsherkenningstechnologieën in de samenleving.

Bronnen & Referenties

- National Institute of Standards and Technology

- American Civil Liberties Union

- European Parliament Committee on Civil Liberties, Justice and Home Affairs

- European Data Protection Board